aus scinexx.de, 13. November 2024 2001, Odyssee im Weltraum. zu Jochen Ebmeiers Realien zu Philosophierungen,

Planlose KI? Auch wenn KI-Modelle uns scheinbar souverän den Weg zeigen können oder Aufgaben lösen – ihnen fehlt ein entscheidendes Element: Die künstlichen Intelligenzen bilden kein korrektes Abbild unserer Welt und ihrer impliziten Regeln, wie nun Tests enthüllen. Die KI-Systeme scheitern dadurch beispielsweise beim Routenplanen an Baustellen oder Umleitungen. Auch in Logiktests oder Strategiespielen zeigen sich diese Schwächen. Das birgt Risi-ken im Einsatz von GPT, Claude, Llama und Co.

Der Fortschritt der künstlichen Intelligenz ist rasant. Inzwischen können die gene-rativen KI-Modelle nahezu perfekte Videos und Bilder erstellen, Forschungsauf-gaben lösen oder wie NotebookLM täuschend echte Podcasts aus beliebigen Doku-menten erzeugen. Sie bestehen den Turing-Test und sind uns in vielen Aufgaben schon überlegen. Wenn es ihren Zielen dient, können die KI-Systeme sogar absicht-lich lügen. Das Verblüffende daran: All diese Fähigkeiten entwickeln GPT, Llama, Claude, Sora und Co durch Auswertung von Wahrscheinlichkeiten in den Trainings-daten.

- Aber was unterscheidet die 'künstliche' von natürlicher Intelligenz?

- Auch historisch entstehen das Ich und die Welt miteinander.

Doch was bedeutet für die „Denkweise“ der KI? Bildet sie durch ihr Training auch eine kohärente Sicht der Welt und ihrer Regeln? „Die Frage, ob Große Sprachmo-delle (LLM) solche Modelle der Welt bilden, ist sehr wichtig, wenn wir diese Techni-ken beispielsweise in der Wissenschaft einsetzen möchten“, erklärt Seniorautor Ashesh Rambachan vom Massachusetts Institute of Technology (MIT). Auch bei KI-Aufgaben, von denen Leben abhängen können, ist es essenziell, dass LLMs im-plizite Regeln und Gesetzmäßigkeiten begreifen – auch ohne, dass man sie ihnen explizit beibringt.

Routen durch New York als Testfall

Ob gängige KI-Systeme eine solche Weltsicht entwickeln, haben nun Rambachan und sein Team getestet. Dafür wählten sie Aufgaben aus der Klasse der sogenann-ten Deterministischen endlichen Automaten (DFA). Dazu gehören beispielsweise die Routenplanung, Spiele wie „Vier Gewinnt“ oder bestimmte Logikrätsel. Typisch dafür ist, dass man eine Reihe von aufeinanderfolgenden Zuständen durchlaufen muss, um die Lösung zu erhalten – beispielsweise das richtige Abbiegen an Kreu-zungen beim Navigieren.

Im ersten Test wurden zwei Version von GPT mit den Routendaten von Taxifahr-ten durch New York trainiert – im Prinzip den Anweisungen, die ein Navi bei sol-chen Fahrten geben würde. Dann sollte die KI selbst als Routenplaner agieren und den Weg zu verschiedenen Zielen in Manhattan angeben. Wie erwartet, schnitt die künstliche Intelligenz sehr gut ab: „Das Transformer-Modell gab in fast 100-Pro-zent der Kreuzungen die richtige Anweisung und schien sogar die aktuelle Position zu kennen“, berichten die Forscher.

Unmögliches Straßennetz

Doch das änderte sich, als das Team Baustellen, Straßenblockaden und andere Veränderungen einbaute. „Ich war überrascht, wie schnell die Leistung in den Keller ging, sobald wir einen Umweg hinzufügten“, berichtet Erstautor Keyon Vafa von der Harvard University. „Wenn wir nur ein Prozent der Straßen blockierten, sank die Quote der korrekten Zielführungen von fast 100 auf nur noch 67 Pro-zent.“ Die künstliche Intelligenz „verirrte“ sich in den Straßen von New York.

Der Grund dafür zeigte sich, als die Forscher sich die von der KI im Verlauf des Trainings und der Aufgaben angelegten „mental Maps“ anschauten: „Die resultie-renden Karten zeigen wenig Ähnlichkeit mit den echten Straßen von Manhattan. Sie enthalten Straßen mit unmöglicher Orientierung und nicht existente Verbindun-gen in ‚Luftlinie'“, berichtet das Team. „Das enthüllt, dass die zugrundeliegenden Weltmodelle dieser künstlichen Intelligenz nicht kohärent sind.“

Scheitern an impliziten Gesetzmäßigkeiten

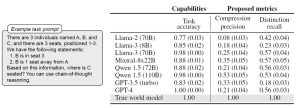

Diese fehlende oder falsche Weltsicht der KI ist jedoch nicht nur für die Navigation problematisch: Auch bei Tests mit Strategiespielen wie Reversi und Vier Gewinnt sowie Logikrätseln zeigt sich fehlende Einsicht in die dahinterstehenden Prinzipien. So konnten die anhand realer Spielzüge trainierte KI-Modelle GPT-4 und Llama zwar die Spiele gewinnen. Sie erkannten aber beispielsweise nicht, ob sie in zwei Durchgängen identische Spielzustände erhielten oder dass verschiedene Eröffnun-gen letztlich zum gleichen Ergebnis führen können.

Ähnlich lief es beim Logiktest, in dem anhand einer Sprachaufgabe die Sitzreihen-folge von drei Leuten auf einer Bank ermittelt werden sollte. Wurde die Aufgabe leicht anders formuliert, erkannte die künstliche Intelligenz nicht mehr, dass es im Prinzip die gleiche Aufgabe war. „Kein KI-Modell erreicht dabei mehr als 40 Pro-zent“, berichten Vafa und seine Kollegen. Auch hier fehlte den KI-Systemen ein übergeordnetes Verständnis, eine kohärente Weltsicht.

Schwachstelle der KI-Modelle – noch

Nach Ansicht der Forscher bestätigt dies eine wichtige Schwachstelle der künstli-chen Intelligenzen: Selbst wenn sie verblüffende Leistungen erbringen und komple-xe Aufgaben souverän meistern: Noch reichen ihre Fähigkeiten nicht aus, um sich aus ihren Trainingsdaten und Erfahrungen immer ein korrektes Abbild der Welt und ihrer Gesetzmäßigkeiten zu machen. Wird ihnen dies nicht explizit beigebracht, können sie dadurch an unerwarteter Stelle scheitern.

„Wir sehen, wie diese KI-Modelle beeindruckende Dinge tun, und denken daher, sie müssen das Prinzip dahinter verstanden haben“, sagt Rambachan. Aber bisher sei dies nicht immer der Fall. Das könnte dann gefährlich werden, wenn eine für essenzielle Aufgaben eingesetzte künstliche Intelligenz in einem Kontext bestens funktioniert, dann aber unerwartet scheitert. „Es wäre daher immens wertvoll, wenn wir generative KI-Modelle entwickeln, die auch die zugrundeliegende Logik selbstständig erfassen können“, so der Forscher. (Preprint arXiv, 2024; doi: 10.48550/arXiv.2406.03689)

Quelle: Massachusetts Institute of Technology (MIT) - 13. November 2024 - von Nadja Podbregar

Nota. - Noch? Das dürfte so bleiben - dass der künstlichen Intelligenz ein Bild der Welt vorgesetzt werden muss, damit sie eine erkennt; weil sie nämlich selber schlech-terdings nicht in der Welt ist - sondern in einem Laboratorium, in dem ihr alle Da-ten, die sie kennen soll, von außen zugeführt werden müssen,

Natürliche Intelligenz existiert in einem lebenden Organismus, wo er alles, was er weiß, in der Welt erfahren muss, in der er - und sei es durch lesen - tätig ist: Er kann es selber herausfinden. Das kann eine Mascine nicht. Sie kann sich von der Welt kein Bild machen, weil sie es gar nicht braucht.

Wirkliches Wissen stammt aus Erfahrung, und die entsteht durch die Verbindung von Begriffen und Anschauungen. Eigne Anschauungen hat eine künstliche Intel-ligenz nicht.

JE

Keine Kommentare:

Kommentar veröffentlichen