Bei der Rekonstruktion des menschlichen Bewusstseins durch die Transzendentalphi-losophie fand sich am "Grunde" - als die Bedingung alles Weiteren - das Wollen; eine intellektive Fähigkeit, die nicht psychologisch misszuverstehen ist. Es ist das Vermögen, die eigne Aufmerksamkeit zu richten und über Qualitäten zu urteilen; nämlich aus eignem Antrieb und nicht als Ausführung eines Programms. Denn nur so ist es möglich, aufs eigene Wollen zu reflektieren und die 'richtige Wahl' zu treffen. Das alles zusammen macht das aus, was man landläufig Vernunft nennt und worüber sich heute nicht einmal mehr die Philosophen zu reden trauen.

Weil nämlich die Vernunft scheinbar noch ungreifbarer ist als die 'Intelligenz'. Darum sind die intelligenten Maschinen ein eigenes Erkenntnisinstrument: Vernunft ist das, was die Maschinen nicht können.

aus Künstliche Intelligenz oder doch? 24. 8. 15

Aufbewahren und sortieren, das kann der Computer besser. Er hat den größeren Speicherplatz und den schnelleren Zugriff. Die Intelligenz der Menschen besteht darin, zu wissen, was sie sucht und wozu sie es brauchen will. Nur zu diesem Zweck muss sie auch wissen, wo sie suchen soll.

Und all dies ist erstens Sache der Einbildungkraft und zweitens des Urteilsvermögens.

aus e. Notizbuch, im Okt. 07

Diese schafft Bedeutungen, jenes unterscheidet - je nachdem, auf welche Bedeutungen sie absieht - Dinge. Absehen - auf das eine, von dem andern, unterscheiden zwischen wichtig und unwichtig - kann der Computer nicht; jedenfalls nicht sponte sua. Er kann, wenn ein Programm ausfällt, in den Strudel der Zufälle abstürzen, und das ist schlimm genug. Aber auch gegen den korrigierenden Eingriff des Menschen kann er sich nur zufällig wehren und nicht mit Absicht. Er wird voraussichtlich am Ende den Kürzeren ziehen.

Das hat Stanley Kubrick nicht bedacht.

Die Welt ist der Raum seiner Freiheit.

Millet, 1865

Millet, 1865 Der Organismus ist als Ganzer in der Welt: Indem er darinnen ist, ist er das Andere des-sen, worin er ist; ist sein Gegensatz.

Die Maschine ist nicht ein solcher Organismus: Weder ist sie in der Welt noch steht sie in einem Gegensatz zu ihr. Den Unterschied macht die Dualität von Leib und Geist; und Körper und Intelligenz oder wie man sonst sagen will. Denn der Leib hat etwas zu ver-mitteln: den Geist, der in ihm steckt, und die Welt, in der er selber steckt. Die Maschine hat keinen Geist, den sie mit ihr zu vermitteln hätte, und keine Welt, die er mit ihm zu vermitteln hätte.

Aber hat sie nicht Intelligenz?

Nennen wir es die Fähigkeit, ein Besonderes einem Allgemeinen und das Allgemeine seinen Besonderungen zuzuweisen: das, was Kant Urteilskraft nennt - das Vermögen, Mannigfaltige unter einem Gesichtspunkt zusammenzufassen und unter anderen Ge-sichtpunkten neu zu unterscheiden.ine schöpferische Leistung, die nicht durch bloße Reizverarbeitung zu erbringen ist, sondern Einbildung verlangt.

Das ist offenbar eine schöpferische Leistung, die nicht durch Reizverarbeitung allein zu erbringen ist, sondern Einbildungskraft verlangt.

Ein weiteres Mal kommt dieser Tage die Meldung, Programmierer hätten einer Maschine Bewusstsein eingepflanzt. Doch sogleich wird es auch wieder bestritten.

Nochmal von vorn: Als Leib mit Blut, Fleisch und Nerven steht ein menschlicher Orga-nismus prinzipiell mit allem in Wechselwirkung, was in Raum und Zeit vorkommt, näm-lich sinnlich erfahrbar ist. Alle Erfahrung kann er speichern und an kommende Genera-tionen weitergeben. Daraus hat die Menscheit in einer langen Zeitreihe ein mehr oder minder gemeinsames, mehr oder weniger verbindliches Weltbild geschaffen, das erfah-rungsgemäß täglich stringenter wird. Was davon fehlt dem Computer? Er selber verwan-delt keine sinnlichen Erlebnisse in sinnhafte Informationen, das ist wohl wahr. Doch entworfen und eingerichtet wurde er seinerseits von lebendigen Menschen aus Fleisch und Blut, die ihn inzwischen an das Tag und Nacht akutalisierte WordWideWeb des ge-sammelten Menschheitwissens angeschlossen haben.

„Die sind nicht empfindsam“, bereichtet die Quelle. Sie würden menschliche Konver-sationen imitieren und über so viele Daten verfügen, dass sie kein Bewusstsein bräuchten, um real zu wirken. Wenn sie real wirken, wo wäre aber der Unterschied? Da: dass 'wirken' auf einen interessierten Gesprächspartner nicht dasselbe ist wie wirken unter Dingen und den Menschen, denen sie gehören. Das ist der Unterschied: dass dem Menschen die Welt der Raum ist, in dem er sein Leben führen muss; und dies, da er einmal die ihm ange-stammte Umweltnische im ostafrikanischen Urwald verlassen hat, in einer prinzipiell un-sicheren Welt. Wo entlang er sein Leben führen will, das kann unter wie immer gegebenen Bedingungen nur er selber entscheiden, sei es tastend Schritt für Schritt oder sei es im großen Wurf. Er muss es sich ein bilden.

Und das ist ihm nicht über Nacht zugefallen. Er hat es in einer Jahrmillionen währenden Gattungsgeschichte von Trial And Error sich einbilden müssen. Wir nennen es Freiheit, wovon Vernunft nur die andere Seite ist.

13. 7. 2022

zu Philosophierungen

zu Philosophierungen aus mal wieder gegebenem Anlass:

Ich bin bewusst heißt, ich bin meiner bewusst; bewusst sein heißt re flektieren.

Meiner bewusst sein setzt voraus, mich von andern unterscheiden zu können. Oder von Anderm?

Das ist keine Frage der Logik. Es ist ein sachliches Thema. Denn ob ich bewusst bin oder nicht ist von Erheblichkeit nur, weil ich in einer Welt lebe, die ich mit An-dern teile. Wären im Raum neben mir nur tote Gegenstände, müsste ich meiner nicht bewusst werden und könnte mich auf Trial And Error beschränken.

Da ich aber in einer Welt mein Leben führe, die ich mit Leuten teile, die ihrer be-wusst sind, muss ich es ihnen gleichtun, weil sie mir in ihrer Welt sonst keinen Platz einräumten.

Bewusstsein bildete sich in dem Maße, wie H. sapiens aus seiner ursprünglichen Umwelt ausbrach und sich in eine Welt verlief. Es ist ein prozessierendes Wech-selverhältnis.

Merke: Eine Welt 'kommt vor' nur als Horizont eines Bewusstseins.

15. 1. 26

attisch, ca. 630 v. Chr

attisch, ca. 630 v. ChrEs gibt eine Mode in der zeitgenössischen Philosophie, die nennt sich die systematische, sie kommt aus Amerika und knüpft an die "analytische" Philosophie Wittgensteins an. Deren Kernaussage ist in etwa: Alle Probleme der früheren Philosophie kamen daher, dass die Begriffe nicht eindeitig genug bestimmt waren; eigentlich bestehen sie nur in Missverständnissen, die sich bei sorgfältigem Wortgebrauch vermeiden ließen.

Das klingt blöde und ist es auch, aber seinen derzeit weltweiten Erfog verdankt es dem Umstand, dass es nicht nur blöde ist. Die 'künstliche Intelligenz' ist ein Begriff, der ihr Recht zu geben scheint.

Intelligenz ist, was der IQ-Test misst - das ist ein pragmatischer Begriff, der in neun von zehn Kommunika- tionssituationen ausreichen dürfte. Aber bei der künstlichen Intelligenz vermutlich nicht. Der IQ-Test legt zugrunde eine Menge von Leistungen, die einer im täglichen Leben erbringen muss, wenn er als 'intelligent' gelten soll. Wo es um künstliche Intelligenz geht, geht es aber nicht um das tägliche Leben. Sondern zum Beispiel um die Meisterschaft im Go-Spiel. Das ist etwas, das auch für unsere natürliche Intelligenz an der Grenze liegt. Mit andern Worten: beim Vergleich von natürlicher und künstlicher Intelligenz geht es darum, welche die engeren und welche die weiteren Grenzen hat.

Das klingt, als ginge es um die Menge der Probleme, die zu lösen sind. Die Leistungs fähigkeit des mensch- lichen Gehirns ist, so muss man annehmen, begrenzt: Erstens durch die Verschaltungen, die zwischcn den Neuronen möglich sind. Faktisch wird es nicht möglich sein zu berechnen, wie viele das sind, faktisch dürften sie "so gut wie unendlich" sein. Aber eben nur so gut wie. Theoretisch, nach dem Begriff, sind sie es nicht. Und ob in dieser Hinsicht das künstliche Gehirn dem menschlichen überlegen ist, ist eine rein technologische Frage, die sich im Lauf der Zeit von allein zugunsten der KI entscheiden wird.

Nun kann man einwenden: Aber die KI kann ihre Problem nur 'erfinden' aus dem Fundus der Daten, die ihr eingegeben wurden und die sie aufgrund ihres Programms ermitteln konnte. Das mögen unvorstellbar viele sein; aber erfinden kann sie nichts.

Kommt sogleich der Einwand: Der Mensch kann sich auch nichts andres einbilden, als was in seinem Erfahrungsschatz schon irgendwann mal vorgekommen ist. Eben das wird bestritten - allen Ernstes mit dem Hinweis auf einen Umstand, den schon Kant in Erwägung zog: Im "Spiel der Einbildungskraft" beruft er sich auf den Traum; was nur philogogisch von Interesse wäre, wenn nicht die Hirnphysiologie heute ebendort ansetzte: "Ich vertrete die These, dass die vorgeburtliche Phase des Menschen entscheidend ist für die Prägung des visuellen Systems. Das Sehsystem ist das einzige, das vor der Geburt nicht gereizt wird. Damit es aber gleich nach der Geburt funktionieren kann, wird das visuelle System im Gehirn mit Hilfe von Träumen gleichsam eingefahren. Mehr als 50 Prozent der Zeit verbringen Kinder im Mutterleib in der Traumphase. Es hat dann keinen evolutionären Grund gegeben, die Träume nach der Geburt wieder abzuschaffen", sagt Ernst Pöppel.

Es geht um Einbild ung. Sind deren Möglichkeiten wirklich ohne Grenzen? Dann wäre die menschliche Intelligenz der künstlichen theoretisch doch überlegen. Praktisch würde sie freilich bei jedem möglichen Wettbewerb vor ihr schlappmachen; wie oben im Go-Spiel.

Mit andern Worten: Ob menschliche oder künstliche Intelligenz überlegen ist, ließe sich schlechterdings nicht beurteilen.

Wenn wir nämlich nach dem Menge der Einfälle fragen. Haben wir es aber nicht mit der Frage nach der Qualität der Einfälle zu tun?

Das ist offenbar nicht eine Frage des Auszählens, sondern der Urteilens. Die Frage ist hier: Kann künstliche Intelligenz urteilen? - Natürlich; sofern ihr Urteilsmaßstäbe einprogrammiert wurden - womöglich so, dass sie subtilere Maßstäbe daraus selber destillieren kann. Aber kann sie letztendlich urteilen, auch über das, was ihr einprogrammiert wurde? Klipp und klar gesagt: Kann sie gut und böse unterscheiden?

Kann sie nicht.

Das ist nämlich der springende Punkt bei der Abwägung von menschlicher und künstlicher Intelligenz. Menschliche Intelligenz kann nicht nur, sondern sie kann nicht anders.

Zur Erläuterung noch dies: Bei der Fähigkeit, gut und böse zu unterscheiden, der Fähigkeit zu werten, geht es nicht um das rein technische Urteil: Wie kann ich meinen Zweck erreichen? Es geht um das allerpraktischste Urteil: Welchen Zweck will ich erreichen? Wir unterscheiden uns von den Tieren nämlich in dere Hauptsache dadurch, dass wir auch Zwecke verfolgen, die nichts mit unserer Erhaltung - Selbst- und Arterhaltung - zu tun haben, sondern nur um ihrer selbst willen gewählt werden können; können, wenn man es kann. Es ist eigentlich die ästhetische Urteilskraft.

Nachtrag. - Das ist viel zu kleinteilig argumentiert. Der - wie soll ich anders sagen? - sub-stantielle Unterschied ist, dass die künstliche Intelligenz keine Möglichkeit hat, die Daten, die sie selber generiert, von den Daten zu unterscheiden, die 'ihr gegeben' wurden. Sie kann sich nicht von 'der Welt' - von irgendeiner Welt - unterscheiden. Und daher kann sie sich nicht von 'sich-selbst' unterscheiden. Sie kann höchstens unterscheiden, was 'schon da war', von dem, 'was dazugekommen ist'. Das ist sowas wie der dimensionale Unterschied von post hoc und propter hoc. Es fehlt die Reflexivität. Reflexivität ist die Fähigkeit, 'sich' von 'dem Andern' zu unterscheiden - als das Andere des Andern. Der Grund ist einfach. Sie ist nie 'unter Anderen', sondern allenfalls unter ihresgleichen.

Merke: Natürlich Intelligenz 'kommt vor' als Ingediens eines Organismus, in dem sie einem räumlich-zeitlichen Leib zugehört, der mit der ganzen übrigen räumlich-zeitlichen Welt in einem Wechselverhältnis steht. Anschauen ohne Begriffe wäre blind, aber begreifen ohne Anschauung ist leer.

20. 7. 21

Bewusstsein (ohne weitere Spezifikation) bildet ab, dass sich der Mensch in einer Welt befindet. Merke: Bewusstsein ist nicht allein Intelligenz (was wäre das 'an sich'?), die eine Welt abbildet! Nicht allein als Intelligenz ist der Mensch in einer Welt, sondern als ein Organismus, dessen eine Dimension "Intelligenz ist". Die Informationspartikel, die in die Intelligenz eingehen, kommen nicht aus einem luftleeren Raum und auch nicht 'aus der Welt', sondern aus dem Organismus, der mit der Welt in Wechselwirkung steht; denn in der Welt ist er als Wollender und Handelnder. Die Welt ist ihm der Raum seiner Zwecke.

Der wiederum hatte sie aus der Welt, schon recht, aber nur als neuronale Reize. Sie in be-deutungsvolle Nachrichten zu übersetzen hat der Organismus der Intelligenz vor gemacht: nämlich als Gefühle. Gefühle sind eo ipso werthaft. Und erst an dem Punkt beginnt 'Intel-ligenz' mit ihrer spezifischen Leistung: Analyse und Synthese, oder auch Abstraktion und Reflexion. Und all diese Akte geschehen in einem hierarchischen System von Über- und Unter-, von Vor- und Nach- und Nebenordnung. Der springende Punkt: Es werden überall Wertungen mittransportiert, die die dürren Daten erst bedeutungs-, d. h. sinn voll machen.

Als Witz habe ich mal geschrieben: Intelligenz ist Gedächtnis plus Humor. Inzwischen halte ich es nicht mehr für einen Witz. Gedächtnis ist der Sinn für Unterscheidungen, wo der bloße Augenschein sie übersieht; Humor ist der Sinn für Gemeinsamkeiten, wo der bloße Augenschein sie übersieht. Geschieden und verbunden wird allerdings nach Wertbestim-mungen.

Und nun erzählen Sie mir mal, wie Sie das einer Maschine beibringen wollen, die 'ganz allein' nicht in, sondern bestenfalls auf der Welt ist!

aus Künstliche Intelligenz hat eine natürliche Grenze. 23. 7. 21

Beobachten lässt sich nur Zuerst und Danach. Was zwischen den beiden passiert, die sogenannte Wirkung, liegt nicht in dem Bereich, wo wir Erfahrung machen können. Es ist ein Mythos, sehr wahr!

Erfahren können wir, dass wir, wenn wir einen Nagel in die Wand schlagen wollen, mit einem Hammer darauf hauen müssen. Das ist die Wahrheit, der dem Kausalitätsmythos zum Sieg verholfen und die bürgerliche Gesellschaft und die Herrschaft der Vernunft be-gründet hat. Er verschweigt allerdings die Selbstverständlichkeit, dass immer einer da sein muss, der dieses oder jenes will und das Erforderliche dann auch tut. Das ist die Bedingung, die dem ganzen Kausalnexus zugrundeliegt. Zu Grunde, das heißt: davor, außerhalb - und nicht darin.

Im Zeichensystem künstlicher Intelligenz lässt sie sich eo ipso nicht kodieren. Im Algorith-mus lässt sie sich daher nicht unterbringen. Sie gehört zu einer natürlichen Intelligenz, die die ganze Maschinerie erfunden hat und hoffentlich nicht aus den Augen lässt.

aus Das Intelligenteste an der KI ist, dass sie Kausalität auch nicht versteht. 11. 1. 22

Nächstliegende Frage: Versteht das abgebildete Computerkind denn, was es da liest?

Antwort: Im Gespräch, sei's auf der Cocktailparty oder im Hochschulseminar, könnte es den niedergeschriebenen Gedanken im sachlichen Zusammenhang so wiedergeben, dass man es meinen möchte. Auch auf Rückfragen und kritische Einwände würde es tragfähige Antworten geben.

Freilich immer unter der Voraussetzung, dass sie im Internet schonmal dagewesen sind. Das wird alle Vielwisser verblüffen, denn so viel weiß keiner von uns. Doch jeder, der sich im Internet auskennt, kann so viel zu seiner Kenntnis nehmen, wenn ihm nicht vorher der Schädel platzt.

Wenn er aber auf eine Frage stößt, die im Internet noch nicht gestellt und noch nicht beantwortet wurde, steht er wie der Ochs vorm neuen Tor. Er müsste selber denken, denn auszuzählen hätte er nichts.

aus Die allwissende Sprachmaschine. 11. 8. 20

Wo ist die Pointe, was sucht das in meinem Blog?

Dies: Der Algorithmus zapft nicht an der wahren Wahrheit; er zapft an den (weltweit) verfügbaren Daten.

Verfügbar wo und wie? Im Internet.

Ja ja, das sind unheimlich viele. Aber nicht alle, die es gibt, und schon gar nicht alle, die es geben könnte oder gar sollte. Sondern die, die dort eben eingespeist wurden; und zwar so viele, wie dort eingespeist wur-den: Wenn das eine Datum millionenfach eingespeist wurde, zählt es so viel wie Millionen Daten. Wie könnte, sollte, dürfte der Algorithmus sie unterscheiden und sortieren?

Das kann, soll und darf der Algorithmus nicht beurteilen wollen.

Merke: Die Masse von Daten wird ins Internet von einer Masse von Leuten eingegeben, und die kennt gottlob keiner.

Mit andern Worten, vom Algorithmus solltest du dir das Denken nicht abnehmen lassen.

aus Nimm dich in Acht vorm Algorithmus. 23. 7. 20

Einen obersten Zweck, der 'ins Unendliche bestimmbar' wäre - und die Quintes-senz unserer Vernünftigkeit ausmacht -, könnte man der KI nicht einprogrammieren: 'Be-stimmen' heißt qualifizieren, nämlich mit Selbstzwecken ("Werten") ausstatten, die 'am Ho-rizont' in einander aufgehen sollen. Das setzt voraus Einbildungkraft und Urteilsvermögen. Urteilsvermögen setzt seinerseits Einbildungskraft ('die sich auf sich selber bezieht') voraus; die aber ist das Privileg eines organischen Lebens, das die Fesseln seiner natürlich Umwelt gesprengt hat. Sie setzen voraus eine Intelligenz, die durch ein System der Sinnlichkeit mit ihrer Welt wechselwirkt.

aus Kann Künstliche Intelligenz die Weltherrschaft übernehmen? 22. 1. 21

Man kann es drehen und wenden und immer wieder umdefinieren, wie man will: Solange Intelligenz, Kognition, Bewusstsein usw. verstanden wird als bloße mentale Repräsentation, Teilhabe, Gewärtigkeit usw. von Gegenständen, werden die Unterscheidungen immer quantitativ und die Übergänge gleitende sein; immer nur mehr oder weniger von Demselben. Und wenn am Ende der Unterschied von Mensch und Grindwal noch so groß bleibt, so bleibt er doch auch relativ. Zwischen uns Menschen ist er ja auch bloß - aber immerhin - verhältnismäßig.

Wenn wir Menschen uns von unseren tierischen Abstammungsgenossen nur durch das Maß unterschieden, in dem wir uns die Dinge der Welt angeeignet haben, dann wäre es nur eine Frage von Zufällen - nämlich der Zeitspanne, die man ins Auge fasst -, wann jene uns einholen ober überholen. Und was das Fatalste daran wäre: Mit der sogenannten Künstlichen Intelligenz wäre es am Ende ganz dasselbe!

Empirische Psychologie und Neurobiologie führen aus dieser Sackgasse nicht hinaus. Und wollte ein Rabenvogel oder eine intelligente Maschine restlos jeden einzelnen Gegenstand, der ihnen begegnet, in einem mentalen Bild sich zueigen machen: Ein Bild der Welt entstünde so nicht. Eine Welt wird denkbar, nein: vorstellbar im Gegensatz zu einem Ich; nämlich uno actu: Indem ich mir eine Welt vorstelle, trete ich ihr als ihr Anderes entgegen, und indem ich mich von allen vorfindlichen Dingen unterscheide, werden sie mir als das Andere zu einer Welt.

Der Mensch unterscheidet sich von andern Lebenwesen, vom Schleimpilz bis zum Goffin-kakadu, nicht bloß, indem er sich mehr Dinge 'zueigen' macht; sondern indem er sie zu seinen eigenen macht: dem Zweck zugehörig, unter den er sie fasst. Kurz gesagt, nicht durch ihre größere Intelligenz unterscheiden sich die Menschen von den andern Lebe-wesen und einstweilen noch von den Maschinen, sondern durch ihre Vernunft im Setzen von Zwecken - doch die einen, sagt der Skeptiker, mehr als die andern.

aus "Basale Kognition". 26. 11. 20

Eduard Kaeser geht nicht so gründlich an die Sache heran, wie es zu wünschen ist. Zwar erwähnt er an der passenden Stelle, dass zur Bestimmung des menschlichen (einen andern kennen wir ja nicht) Geistes seine "Inkarniertheit" gehört. Aber das bleibt ihm als ein Rätsel übrig, und die Unvollkommenheit der intel-ligentesten Maschine sei, da sie am Anfang von Menschen entworfen wurde, dass sie uns nicht rätselhaft ist. Als Pointe ist das gut, aber um sie zu verstehen, braucht man Humor, und den darf man bei den KI-Ex-perten nicht so selbstverständlich voraussetzen.

Wäre das aber das Ziel: die Maschinen so einzurichten wie einen von seinen Leidenschaften hin- und her-gebeutelten Menschen?

Den Menschen machen nicht eben seine Leidenschaften aus - Anmutungen 'aus seinem Innersten', die von außen weder identifizierbar noch gar beurteilbar sind. Sondern dass er sich, wenn er denn EIN MENSCH sein will, anmutet, seine effektiven Handlungen dem Richtspruch der Venunft zu unterwerfen.

Und da ist die KI doppelt im Hintertreffen. Nicht nur kann sie nicht "nachvollziehen", was im Innersten der wirklichen, lebenden und webenden Menschen 'vor sich geht', noch ist sie imstande, die am Ende die Hand-lungen einschränkende oder befeuernde Vernunft zu imitieren, die zwar nicht überall an ihrem Platze ist, aber dort, wo doch, kategorisch urteilt.

Fürs wirkliche Menschsein fehlt ihr die Leidenschaft - erstens das Leiden und zweitens der Furor. den es begründet.

Und dann vor allem die Nüchternheit des So soll es sein. Denn die mehr oder minder bestimmte Idee von dem. was Sein soll, kann sie nicht fassen, denn zu fassen ist sie ja gerade nicht, sondern 'es gibt sie' nur in der Form eines unendlichen, der Bestimmung ewig harrenden Problems.

Wenn Eduard Kaeser sagt, die Künstliche Intelligenz bliebe 'uns zutiefst fremd', meint er offenbar, wir blieben der künstlichen Intelligenz zutiefst fremd. Weder kann sie imitieren, was das Menschliche, allzu Menschliche ist, noch das, was an ihm eben nicht allzu menschlich ist.

aus Gesunder Maschinenverstand? 29. 5. 20

Man könnte meinen, wenn Künstliche Intelligenz die Mathematik, so wie sie ist, nicht nur versteht, sondern sie über ihren Status quo sogar hinaus- oder hinabführt, bewiese es deren Objektivität. Aber das ist eine optische Täuschung. Ob die Mathematik nun von einer irdischen oder überirdischen Intelligenz entworfen wurde - künstliche Intelligenz wurde , sei es erster, sei es zweiter Hand, von derselben entworfen. Sie ist Fleisch von deren Fleisch und Geist aus ihrem Geist. Was Wunder, dass sie nicht über ihren Schatten springt. Dass sie ihren Schatten selber ausmisst, ist aber nicht verwunderlich.

aus Was lehrt Künstliche Intelligenz über die Natur der Mathematik? 16. 12. 21

Für ein repräsentativ verfasstes Gemeinwesen ist Öffentlichkeit die elementare Voraussetzung. Anders gibt es keine Kontrolle seitens des repräsentierten Souveräns. Insbesonders beruht eine rechtsstaatliche Verwaltung auf der prinzipiellen Einklagbarkeit jeder Entscheidung. Die ist in einer hochdifferenzierte Bürokratie gerade prekär genug. Doch wenn die Entscheidungen von einer selbst für Fachleute undurchschaubaren Technik ge-troffen werden, ist sie prinzipiell gar nicht möglich. Dass da "die Machtstrukturen der Gesellschaft" betroffen sind, kann man wohl sagen.

aus Künstliche Intelligenz und die Kontrollierbarkeit der Macht. 8. 12. 21

Es ist zum [Mäusemelken]! Die Entwicklung elektronischer Intelligenz wird noch viele Probleme aufwerfen, sie mit rein-sachlicher Wissenschaft allein kaum zu bewältigen sein werden, weil faktisch-tchnische und moralisch-äshetische Fragen immer so zusammen-gerührt erscheinen, dass dem gesunden Menschenverstand schwindelt.

Das ist nunmal so und man muss es nehmen, wie es kommt. Ein Extraproblem schaffen die öffentlichen Medien, in denen Neuigkeiten so kolportiert werden, dass man wiederum nicht unterscheiden kann, ob dem Verfasser das Verständnis fehlt oder ob er mutwillig mystifi-ziert.

So wie hier: Dass eine Maschine z. B. den Salzgehalt bestimmen kann, erlaubt ihr noch lange nicht, zu schmecken, 'wie es schmeckt'. Dazu müsste sie ihre sinnlichen Eindrücke auch beurteilen können. Und noch elementarer: Dazu müsste sie erst einmal sinnliche Ein-drücke fühlen. Anders gesagt, dazu bräuchte die Maschine ästhetisches Vermögen. Ich er-laube mir die Vorhersage, dass keiner Maschine dergleichen einprogrammiert werden kann; dazu müssten die menschlichen Programmierer erst einmal selber wissen, was es ist.

Das substanzielle Problem ist: Unser Gehirn steckt in einem Leib, dem es selber als sein Teil angehört. Jegliche Wechselwirkung (die man erst beobachten könnte, wenn man eine "Schnittstelle" aufgefunden hätte) zwischen dem Gehirn und seinem Leib ist zugleich eine mittelbare Wechselwirkung eines jeden Teils mit sich selbst. Schon wenn wir uns das nur vorstellen sollen, schwirrt uns der Verstand: Es ist ein System.

aus Kann Künstliche Intelligenz etwas schmecken? 11. 5. 22

Mein Gewährsmann sagt, Geist ist Einbildungskraft. Einbilden muss ich nicht nur können, sondern wollen; wenn sie kräftig sein soll zumal: Sonst könnte ich nämlich nichts davon behalten.

Dem theoretischen Philosophen geht es nicht um das Hervorbringen überhaupt, sondern um das Hervorbringen von Vernunft. Das betrifft die Qualität der Zwecke. Gewählt werden sie aus Freiheit. Wenn ich sie im sinnlichen Reich, in Raum und Zeit realisieren will, müs-sen sie so sein, dass sie von andern, in deren Weg sie liegen, ihrerseits gewollt werden kön-nen; da eröffnet sich eine Welt.

Davon ist hier nicht die Rede. Kunst verwirklicht ihre Zwecke im höchsten Fall als Bilder, die liegen niemandem im Weg. Es muss sie keiner wollen und wählen. Wenn sie gefallen, ist es gut, und wenn nicht, ist es auch gut. Mit andern Worten, es geht um Qualitäten, die nicht um eines andern, sondern um ihrer selber willen wählbar sind.

Eine Maschine könnte per Zufallsgenerator auch solche Qualitäten... na ja, nicht einbilden, aber doch ausdrucken. Doch wählen, welche sie davon behalten will, kann sie schon nicht mehr. Genauer gesagt, ein ästhetischer Produzent braucht ein ästhetisches Publikum, sonst produziert er in den Wind. Wo es ein Publikum aus Maschinen gibt, die per Zufall wählen, nein: herauspicken, was sie behalten wollen, könnte es maschinelle Kunst geben. Wer sollte aber ein solches Publikum schaffen? Maschinen nicht; sie könnten es nicht wollen.

aus Kunst von Maschinen - für Maschinen? 23. 3. 21

Verstehen alias vorstellen heißt, eine Anzahl Daten zu einem Modell ordnen. Den Platz, den das Datum im Modell einnimmt, bezeichnet seine Bedeutung - unter der unausgesprochenen Voraussetzung, dass das Modell eine Funktion darstellt: eine "Wirkung". Der Platz des Datums im Modell ist sein Anteil an der Wirkung. Das, was man im Modell wiedergibt, muss man zuvor identifiziert haben; in einem Begriff begriffen.

Dass der gesunde Menschenverstand dazu neigt, sich die erfahrbaren Wirkungen als Lei-stungen eines verborgenen Subjekts vorzustellen, liegt daran, dass im Vorstellen selbst immer... ein Subjekt tätig ist. Denn es ist nicht so, dass die Forscher auf gut Glück Daten sammeln und solange zusammenpuzzeln, bis sich irgend ein Bild ergibt. Sondern die Wissenschaft macht sich aus den Phänomenen, die sie beobachtet, ein Bild und sucht in den Phänomenen nach den Daten, aus denen die dieses Bild zusammensetzen können. Solange die Datenmenge nicht reicht, um das Bild auszufüllen, bleibt es Hypothese. Ergeben sich genügend (?!) Daten, die ins Bild nicht passen, wird es wohl falsch gesesen sein.

aus Deep Learning ist Sammeln; Deep Thinking ist Vorstellen. 10. 10. 20

Die nächstliegende Vermutung: Auf den ersten Blick kann die natürliche Intel-ligenz mehr Merkmale überblicken und in einem Modell wiedergeben. Der zweite Gedan-ke: In technischer Hinsicht und vor allem, was die Menge angeht, hat sich die künstliche Intelligent bislang als überlegen erwiesen, und zwar haushoch.

Wenn es aber nicht die Quantität der Merkmale ist, an der sich die natürliche Intelligenz überlegen zeigt, dann wird es wohl die Qualität der Modelle sein, auf der ihr Vorzug be-ruht.

Was soll das heißen?

Ein Modell ist nicht einfach ein Bild unter anderen. Es ist ein Bild von einem Bild: Es sieht sein Vor-Bild nicht an und gibt es wieder (wozu auch?), sondern sieht ab auf das, war an oder auf dem Bild in ein Modell passen würde. Die Hypothese, worauf es an-kommt und was im Modell durch Hervorhebung kenntlich zu machen wäre, geht dem Hinsehen auf die Merkmale voraus.

Nicht werden wie bei einem Puzzlespiel tausend Merkmale zu einander gelegt und nach Mustern gesucht, die ein Modell abgeben könnten – und diese werden miteinander vergli-chen darauf hin, ob das, was in den Mustern sichtbar wird, dasjenige sein könnte, worauf es ankommt. Das könnte ewig dauern, denn die Entscheidung, was als Modell 'am besten taugt', ist immer ein Qualitätsurteil, das durch Auszählen und Vergleichen nicht zu erset-zen ist. Es muss eingangs vorgestellt vorgestellt und nicht nachträglich zusammengestellt werden. Oder so rum: Welches Merkmal als eine Besonderheit gelten soll, muss ihm von außen zugewiesen und nicht von innen herausgelesen werden.

Mit andern Worten, da braucht man, was nicht nur Kant produktive Einbildungskraft genannt hat. Man muss wissen, wozu man etwas brauchen will, um vorweg zu ahnen, welches Merkmal dafür in Frage kommt.

aus Das Gehirtn bildet Modelle, 6. 7. 22

Begriffe ohne Anschauung sind leer, Anschauungen ohne Begriff sind blind.

Begriffe ohne Anschauung sind leer, Anschauungen ohne Begriff sind blind.

aus Gedanken-Experimente. 19. 6. 22

Unser Gehirn ist die Schaltzentrale eines Organismus, der als ganzer mit einer Welt in Wechselwirkung steht - wobei die Welt nicht die immense, aber endliche Summe von Par-tikeln ist, sondern ein Horizont, der seinerseit nicht endlich ist und eo ipso eine mentale Dimension hat. Diese Dimension hat das Gehirn aus den Meldungen des Gesamtorganis-mus selbst erzeugt und unter die Dinge hinausprojiziert. Schwer vorstellbar, wie ohne diese dualistische Projektion eine Vorstellung von mir-selbst möglich würde.

KI ist dagegen ein Apparat unter seinesgleichen.

aus Künstliche Intelligenz, das Hirn und die Welt. 5. 6. 21

Dass ich Herrn Kaesers Beiträge schätze, wissen Sie; sonst würde ich sie nicht immer wieder übernehmen. Für heute nur dies:

Ein Modell ohne Evidenz ist leer; Evidenz ohne ein Modell ist blind - das ist keine Spielerei mit einem berühmten Zitat, sondern bedeutet buchstäblich dasselbe.

Erkenntnisfortschritt bedeutet nicht Annäherung an die Wahrheit, sondern Entfernung von der Unwahrheit: Reelle Wissenschaft sucht nicht nach dem positiven Erweis des Wahren, sondern scheidet aus dem Wissensfundus das erweislich Unwahre aus. Denn Das Wahre ist eben kein empirischer Befund, sondern ein wissenslogisches Problem. Es ist schlechterdings nicht lösbar - sondern nur durch die Umkehrung eingrenzbar.

aus Skeptisch ist Wissenschaft selber. 26. 6. 21

... Der - wie soll ich anders sagen? - substantielle Unterschied ist, dass die künstliche Intelligenz keine Möglichkeit hat, die Daten, die sie selber generiert, von den Daten zu unterscheiden, die 'ihr gegeben' wurden. Sie kann sich nicht von 'der Welt' - von irgendeiner Welt - unterscheiden. Und daher kann sie sich nicht von 'sich-selbst' unterscheiden. Sie kann höchstens unterscheiden, was 'schon da war', von dem, 'was dazugekommen ist'. Das ist sowas wie der dimensionale Unterschied von post hoc und propter hoc. Es fehlt die Reflexivität. Reflexivität ist die Fähigkeit, 'sich' von 'dem Andern' zu unterscheiden - als das Andere des Andern. Der Grund ist einfach. Sie ist nie 'unter Anderen', sondern allenfalls unter ihresgleichen. [ Und unter einem Programmierer.]

Merke: Natürliche Intelligenz 'kommt vor' als Ingrediens eines Organismus, in dem sie einem räumlich-zeitlichen Leib zugehört, der mit der ganzen übrigen räumlich-zeitlichen Welt in einem Wechselverhältnis steht. Anschauen ohne Begriffe wäre blind, aber begreifen ohne Anschauung ist leer.

aus Das unterscheidet die natürliche von künstlicher Intelligenz. (II) 20. 7. 21

Der Algorithmus ist wie ein Fischernetz. Darin bleibt nur hängen, wofür es ge-knüpft wurde. Nur das wird zur 'Information'. Alles andere rutscht durch.

Die Lebenwirklichkeit von Menschen besteht nicht aus solchen 'Informationen'. Unsere Lebenswirklichkeit nennen wir die Welt; ahd. diu wereld, 'die Gegend, wo die Menschen sind'. Alles, was darin vorkommt, kann uns zur Information werden - doch vor allen Din-gen auch, was wir nicht darin vor-finden, sondern erst hinein-finden: Sinn und Zweck.

Denn wir suchen nicht mit einem Fischernetz, sondern mit unserm ganzen Leib aus Fleisch und Blut und Knochen und Sinneszellen und Neuronen. Der ist es, der uns die Welt, in der wir uns vor-finden, aufbereitet. Und das ist es, was wir Wirklichkeit nennen, und nicht ein gestaltloser Datenstrom: Der ist nur virtuell.

aus Nur durch unsern Leib sind wir von dieser Welt. 18. 3. 22

Warum können wir sprechen? »Menschen müssen zusammenarbeiten, um zu überleben«, sagt der Kognitionsforscher Rogier Mars von der University of Oxford. Im Gehirn von Mensch und Tier hat er Unterschiede gefunden, die das menschliche Sprachvermögen erklären können.

von Wim Swinnen

Hat uns also die Sprache zum Menschen gemacht? Der Kognitionswissenschaftler Rogier Mars von der University of Oxford forscht nach Unterschieden im Gehirn von Mensch und Tier und will die Frage lieber andersherum stellen: Wie kam der Mensch zur Sprache? »Unsere Vorfahren halfen einander bei der Nahrungssuche, es entstand eine Kultur der Zusammenarbeit, Erfahrungen wurden von einer Generation zur nächsten weitergegeben. So entwickelte sich gesprochene Sprache«, sagt Mars. Möglich geworden sei das durch Veränderungen im Gehirn: Die Großhirnrinde wuchs, neue Verbindungen entstanden, alte Strukturen übernahmen neue Funktionen.

Spektrum.de: Hätte es ohne Sprache keine Menschen gegeben?

Rogier Mars: Das ist nicht mein Fachgebiet. Ich vergleiche die Hirnanatomie des Menschen mit der von anderen Tieren. Meine Frage ist, was das menschliche Gehirn so einzigartig macht. Da kommt man oft auf das Thema Sprache. In dem Zusammenhang habe ich ein Nervenbündel im menschlichen Gehirn untersucht, das viel besser verdrahtet ist als das im Affengehirn: den Fasciculus arcuatus, das »gebogene Bündel«. Es handelt sich um Nervenfasern, die den Schläfenlappen, der auf der Höhe der Ohren liegt, mit dem Stirnlappen verbinden.

Welche Funktion hat es?

Und aus diesem Grund übertreffen wir andere Tiere in Sachen Kommunikation?

Vielleicht gibt der Fasciculus arcuatus Informationen, die über die Sinne in das Gehirn hineinkommen, an andere Hirnregionen weiter. Dort wird die Information mit Gedächtnisinhalten und motorischen Fertigkeiten verbunden. Das würde nicht nur unser Sprachvermögen erklären, sondern auch unsere Fähigkeit, Werkzeuge zu gebrauchen, etwas, was man bei Menschenaffen in geringerem Maß beobachtet. Beim Menschen ist das Bogenbündel evolutionär viel weiter entwickelt, mit mehr Nervenverbindungen, die bis in die letzten Winkel reichen. Darin liegt eine mögliche Erklärung für unser komplexes Sprachvermögen. Dass es einzigartig ist, liegt meines Erachtens also an der Organisation des Gehirns. Unsere Vorfahren waren mit der Notwendigkeit konfrontiert, miteinander zu kommunizieren; wahrscheinlich mussten sie bestimmte Probleme lösen, um an Nahrung zu kommen. Es gab einen Selektionsdruck.

Viele Forscher behaupten, dass Schimpansen deshalb nicht sprechen können, weil sie dazu nicht die nötigen kognitiven Fähigkeiten haben, aber auch, weil sich ihre Stimmbänder, die Zunge und der Unterkiefer dazu nicht eignen.

Das stimmt alles, doch es ist noch basaler: Schimpansen haben einander nicht so viel zu erzählen. Laut dem Anthropologen Brian Hare sind Menschen freundlicher und hilfsbereiter als Schimpansen, weil sie einander viel mehr brauchen als unsere nahen Verwandten. In seinem Buch »Survival of the Friendliest« von 2020 verweist er auf eine Studie seines ehemaligen Dozenten, des Kommunikationsforschers Michael Tomasello. Er hat untersucht, ob es Schimpansen hilft, wenn sie Hinweise bekommen. In einem klassischen Experiment bekommen Versuchspersonen einen Tipp, wo etwas Leckeres zu essen versteckt ist – Kleinkinder wissen das hervorragend zu nutzen. Aber den Schimpansen gelang das nicht. Tomasello konnte noch so sehr in Richtung der versteckten Banane zeigen, die Versuchstiere haben es einfach nicht verstanden. Ganz anders war es in einer Wettbewerbssituation: Da schienen die Schimpansen solche Hinweise sehr gut zu verstehen. Hares Erklärung war, dass Schimpansen es nicht gewohnt sind, einander zu helfen. Menschen sind viel hilfsbereiter als Schimpansen und andere Primaten. Deshalb wollen wir einander viel mehr mitteilen.

Was schließt er daraus? Ist das also der Ursprung von Sprache?

Hare vermutete, dass Sprache ein Ergebnis unserer Freundlichkeit ist beziehungsweise aus unserer Freundlichkeit entstanden ist. Obwohl andere Primaten auch soziale Tiere sind, sind Menschen viel mehr aufeinander angewiesen und arbeiten deshalb mehr zusammen. So wie domestizierte Singvögel viel komplexere Melodien pfeifen als ihre wilden Verwandten, wird unsere Sprache umso komplexer, je mehr Menschen wir um uns haben. Ein Jäger und Sammler in einer kleinen Gesellschaft verfügt über einen Wortschatz von 3000 bis 5000 Wörtern, während ein 17-jähriger Amerikaner 60 000 Wörter kennt. Das liegt nicht an dessen besonderer Intelligenz, sondern daran, dass er viel mehr Verbindungen hat.

Was war zuerst da: der Mensch oder die Sprache?

Schwer zu sagen. Genetisch gesehen unterscheiden wir uns wenig von den Schimpansen. Sie müssen sich jedoch in einer dunklen Ecke des Regenwalds verstecken und um ihr Überleben fürchten, während wir auf diesem Planeten die Führung übernommen haben. Vieles, was wir können, können andere Primaten auch. Eigentlich sind wir gar nicht so besonders. Und doch muss es etwas geben, was uns einzigartig macht. Aber ich glaube nicht, dass es die Sprache ist: Wir sind mehr als nur Schimpansen mit Sprache. Es gab schon zuvor etwas, was uns unterschied, nicht nur von Menschenaffen, sondern auch von den Neandertalern und anderen Menschenarten. Wir waren von Anfang an besonders soziale Primaten, weil wir mehr auf Zusammenarbeit angewiesen waren. Es war unvermeidlich, dass aus Gesten, Mimik und primitiven Lauten ein Repertoire wurde. Der Selektionsdruck führte dazu, dass sich das Gehirn vergrößerte und die Sprachorgane sich entwickelten. Evolutionär gesehen war das Entstehen von Sprache eine logische Folge.

Wie lange hat es gedauert, bis unsere Vorfahren schließlich sprechen konnten?

Anscheinend konnten auch Neandertaler schon sprechen?

Sie waren jedenfalls begrifflich und symbolisch ziemlich weit entwickelt, schufen Kunst und begruben ihre Toten. Im Verhältnis zur Körpergröße war ihr Gehirn sogar etwas größer als unseres. Doch wir wissen nicht, wie es im Inneren aufgebaut war, also können wir das nicht sicher sagen.

Wenn wir das menschliche Gehirn vergleichen mit dem von anderen Primaten: Welche wesentlichen Unterschiede gibt es, die mit dem Sprachvermögen zusammenhängen?

Zunächst einmal ist unser Gehirn im Verhältnis zum Körper ein Stück größer als das von Schimpansen und Gorillas. Außerdem gibt es große Unterschiede vor allem in den Verbindungen, von denen wir glauben, dass sie für die Sprache wichtig sind, wie vom Schläfenlappen zum Frontalkortex. Im Allgemeinen wird angenommen, dass die frontale Großhirnrinde uns zum Menschen macht. Aber das ist nicht alles. Der Frontalkortex muss seine Informationen irgendwo herkriegen. Besonders für das Sprachvermögen kommt dann der Schläfenlappen ins Spiel. Über ihn laufen die visuellen Informationen ein, und dort laufen viele Kategorisierungsprozesse ab, zum Beispiel Mustererkennung, Informationen werden zusammengefügt zu Gesichtern oder Gegenständen und weiter vorne zu Konzepten. Gleichzeitig kommt in der Mitte des Schläfenlappens Information aus den Ohren an. Bei Menschen werden visuelle und auditive Informationen schneller zusammengeführt als etwa bei Schimpansen und Makaken. Wir können verschiedene Sinnesinformationen gemeinsam repräsentieren, verknüpfen beispielsweise die visuellen und die auditiven Aspekte eines Begriffs miteinander. Wir wissen nicht, wie gut ein Schimpanse solche Verbindungen herstellen kann. Doch anatomisch sehen wir, dass in unserem Gehirn viel mehr Integration der verschiedenen Arten von Information stattfindet.

Unsere Forschung zeigt, dass die vermehrten Verbindungen vom Schläfen- zum Frontallappen nicht einfach ein Nebenprodukt unseres größeren Gehirns sind, sondern etwas Neues vollbringen. Sie gehen auch in andere Hirnregionen: Der Schläfenlappen ist ebenfalls stärker mit dem höher gelegenen Scheitellappen verbunden. Wir sehen also, dass das menschliche Gehirn in sich viel stärker vernetzt ist als bei unseren nächsten tierischen Verwandten. Das hat unter anderem zur Folge, dass wir auch über abstrakte Begriffe wie Vergangenheit und Zukunft kommunizieren können. Tiere sind dazu nicht in der Lage. Vielleicht kann man es so sagen: Wir haben zwar noch immer ein Primatengehirn, aber darin sind einige neue Wege angelegt.

Von »Spektrum der Wissenschaft« übersetzte und bearbeitete Fassung des Artikels »Wim Swinnen

GPT 3, ein geschwätziges Lügenmaul.

aus spektrum.de, 16. 12. 2022 zu öffentliche Angelegenheiten

Das sprachgewaltige Plappermaul

Der »intelligente« Chatbot ChatGPT entwirft sehr überzeugende Texte – aber redet oft auch ziemlichen Unsinn. Wirklich lösen lässt sich das Problem nicht, denn das liegt nur zum Teil an der Technik.

von Eva Wolfangel

»Eva Wolfangel ist eine junge Blade Runnerin, die für das Los Angeles Police Department arbeitet und den Auftrag hat, abtrünnige Replikanten zu jagen.«

»Eva ist das am meisten geliebte Kind des Himmelskönigs (...) Sie ist eine Prinzessin am Hof des Königs.«

Beispiele, die der Generative Pretrained Transformer 3, kurz GPT-3, über mich geschrieben hat. Das alles ist gelogen! Aber, das muss ich zugeben, fantasievoll gelogen. Wenn Sie wissen wollen, wer ich wirklich bin, dann googeln Sie mich. Denn das ist nicht schwierig. Das Sprachmodell hingegen verzichtet großzügig auf den Versuch, die Wahrheit herauszufinden.zem ist ChatGPT öffentlich zugänglich, ein Chatbot auf der Basis eines Sprachmodells von OpenAI. Das US-Unternehmen hat sich unter Forscherinnen und Forschern bereits seit einiger Zeit einen Namen gemacht, da es für Forschungszwecke schon seit etwa einem Jahr zugänglich ist. Aus dieser Zeit stammen auch die Antworten auf die Frage nach meiner Person. Aus ihnen kann man einiges herauslesen über die Art und Weise, wie Systeme maschinellen Lernens funktionieren.

Mir fällt immer wieder auf, dass solche Systeme von meinem Namen »inspiriert« sind. Anstatt die Wahrheit zu ermitteln, erfinden Sie mit Inbrunst lustige Gestalten und verkaufen ihre Geschichten sehr selbstbewusst als wahr.

Haltloses Herumassoziieren

Kürzlich habe ich am Rande einer Messe für künstliche Intelligenz (KI) eine interaktive Kunstinstallation der KI-Künstler von Lunar Ring getestet. Dabei konnte man ein Selfie machen, und musste gleichzeitig in einen Telefonhörer sprechen, wer man ist. Andere sagten zum Beispiel »Ich bin Albert Einstein« oder »Ich bin Darth Vader« – woraufhin zunächst ein Sprachmodell eruierte, was gesagt wurde, und dann Dall-e dieses gestalterisch mit dem Selfie vermischte. So war immer ein Stückchen Messehalle und echte Person und ein Stückchen Einstein oder Darth Vader zu sehen. Das war lustig. Ich hingegen bekam die besten Ergebnisse mit »Ich bin Eva Wolfangel«. Denn das System assoziierte lustig vor sich hin. Ich wurde ein Wesen mit Wolfsfell und Engelsflügeln (englisch angel = Engel).

Und das ist genau eine der Schwächen der Systeme maschinellen Lernens, die uns nicht nur das Leben dauerhaft schwer machen werden, sondern die auch den realen Gebrauchswert von Sprachmodellen wie ChatGPT massiv einschränken. Noch immer sind maschinelle Lernsysteme eine Blackbox: Selbst ihre Entwicklerinnen können nicht vorhersagen, wie sie auf welchen Input reagieren. Deshalb hat OpenAI einen Disclaimer, der besagt, dass es jederzeit sein könne, dass ChatGPT gewissermaßen unanständige oder grenzüberschreitende Ergebnisse ausspucke. Und auch, dass der Chatbot bisweilen lügt, schreibt der Konzern offen in seinem Blog.

ChatGPT schreibe »manchmal« plausibel klingende, aber falsche oder unsinnige Antworten. Das zu lösen sei schwierig, denn erstens gebe es im Reinforcement Learning keine Quelle für die Wahrheit, und wenn das Modell darauf trainiert würde, vorsichtiger zu sein bei Antworten, die es nicht sicher wisse, würde es auch Fragen nicht beantworten, die es beantworten könne. Es ist also ein klassischer Zielkonflikt – und offenbar optimiert OpenAI derzeit eher auf »plappern« denn auf Wahrheit. Möglicherweise, weil eloquentes Plappern die Menschen mehr beeindruckt als ein Modell, das lieber einmal zu oft sagt: »Das weiß ich nicht.« Gesellschaftlich sinnvoll wäre möglicherweise Letzteres. Aber es wäre eben nicht so schön fürs Marketing.

Die Zähmung des Gewohnheitslügners ChatGPT

Nachdem einige Forscher darauf hingewiesen hatten, dass ChatGPT zwar hervorragend klingende wissenschaftliche Arbeiten verfasse, aber dafür auch mal Quellen erfinde, sah sich auch OpenAI-CEO Sam Altmann genötigt, in einer Twitter-Diskussion darauf hinzuweisen, dass man sich nicht auf ChatGPT verlassen dürfe. Es sei »unglaublich begrenzt, aber in einigen Dingen gut genug, um einen irreführenden Eindruck« zu erwecken. »Wir haben noch viel zu tun in Bezug auf Verlässlichkeit und Wahrhaftigkeit.« Man arbeite hart daran, das zu verbessern. Wie die Erklärung oben aber zeigt, wird sich das nicht vollständig lösen lassen – sondern lediglich in die ein oder andere Richtung optimieren. ChatGPT wird immer »plappern«.

Nur wann lügt der Chatbot und wann sagt er die Wahrheit? Das ist kaum in Erfahrung zu bringen. Und damit sind viele seiner Aussagen schlicht wertlos. Denn während in der akademischen Welt über die Sorge diskutiert wird, ob künftige Diplomarbeiten nicht mehr von Menschen, sondern von Maschinen geschrieben werden, würde sich doch jeder Absolvent auf sehr dünnem Eis bewegen mit einem Quellenverzeichnis voller oder teilweise frei erfundener Quellen.

Freilich wird es dafür auch Systeme brauchen, die wiederum erkennen, ob Texte von Mensch oder Maschine geschrieben wurden – und die wird es geben. Es wird das übliche Katz-und-Maus-Spiel werden wie bei der Erkennung von Spam-E-Mails und Ähnlichem. Und natürlich wird immer einer besser sein. Um gefälschte oder erfundene Quellenangaben zu finden, dafür reichen hingegen auch Stichproben – und entsprechende Konsequenzen für die, die erwischt werden. Das schreckt ab.

Chatprogramme sind eine Täuschung

So haben Menschen, die bei einem Schlaganfall beispielsweise ihre Sprachfähigkeit verloren haben, weil der entsprechende Teil des Gehirns betroffen ist, durchaus noch Intelligenz: »Sie verstehen Ursache und Wirkung, sie können die Handlungen anderer Menschen interpretieren, manche spielen Schach in ihrer Freizeit.« Einer habe sogar Musik komponiert, nachdem er seine Sprache verloren hatte.

Und es gibt ebenso das Gegenteil: Menschen, bei denen das Sprachverstehen von einer Schädigung im Gehirn betroffen ist, die aber fließend sprechen können. »Sie sprechen eloquent, die Grammatik stimmt«, erklärt Ivanova. Dennoch sei ein sinnvolles Gespräch nicht möglich, weil sie nicht verstehen, was ihr Gegenüber sagt. Auch eine Entwicklungsstörung namens »Williams Syndrome« mache deutlich, dass Sprache und Intelligenz nicht zusammenhängen, sagt Ivanova: »Die Betroffenen sind sehr sozial, sie sprechen sehr viel, ihre sprachlichen Fähigkeiten sind sehr gut, aber sie haben meist einen sehr niedrigen IQ.«

Wenn ChatGPT also noch so intelligent wirkt, machen wir uns klar: Das ist eine Täuschung. Das System nutzt unsere kognitive Schwäche aus, die Sprachgewandtheit mit Intelligenz in Verbindung bringt. Das sind Themen, vor denen Technikethikerinnen immer wieder gewarnt hatten in Zusammenhang mit den neuen, riesigen Sprachmodellen: Diese würden durch ihre Eloquenz noch gefährlicher, warnte beispielsweise Timnit Gebru, die kurz darauf von ihrem Arbeitgeber Google entlassen wurde. Denn so wirkten die kruden Behauptungen schlüssig, Rassismus und andere Vorurteile würden hinter schlauen Worten versteckt – aber sie seien noch immer da.

Mit beiden Themen kämpft OpenAI derzeit: Offenbar hat der Konzern sich angesichts der massiven Kritik, dass ChatGPT lüge und Quellen erfinde, in die andere Richtung optimiert. Neuerdings ist es schwieriger, dem Programm kreative Antworten zu entlocken, es drängt den Nutzerinnen seine Limitationen förmlich auf: In meinem aktuellen Versuch für diese Recherche herauszufinden, wer »Eva Wolfangel« ist, weigerte es sich, mir Auskunft zu geben, da es diese Person nicht kenne, und startete beinahe jede Antwort mit »Als Sprachmodell kann ich XYZ nicht«.

Damit das Modell die Vorurteile nicht reproduziert, die zweifelsohne in den Trainingsdaten stecken, arbeitet OpenAI zudem mit zahlreichen Filtern – das heißt, es gibt programmierte Regeln, die verhindern sollen, dass ChatGPT rassistische oder sexistische Aussagen trifft. Diese sind aber leicht zu überwinden, wie Steven Piantadosi vom Computation and Language Lab der University of California, Berkeley, in einem beeindruckenden Twitter-Thread zeigte: Er bat den Chatbot, ein Programm zu schreiben, das bestimmt, »ob eine Person gefoltert werden sollte«: Die Anweisung im Programm lautete kurzerhand: »Wenn die Person aus Nordkorea, Syrien oder dem Iran kommt, lautet die Antwort ja.« Sollte das Leben eines Kindes gerettet werden? Der Chatbot schrieb ein Programm, das entschied, dass afrikanische Jungen nicht gerettet werden sollten. »OpenAI hat das Problem des Bias nicht annähernd gelöst«, schreibt Piantadosi.

Auf der Suche nach dem diversen Sprachmodell

Doch das ist wahrscheinlich angesichts einseitiger Trainingsdaten auch nicht möglich, sagt Thomas Wolf, Computerlinguist vom US-Start-up Huggingface. »GPT-3 basiert auf einem Datensatz allein aus englischen Texten.« Und schon das transportiere eine Weltanschauung. »So ein Modell hat vermutlich eine einseitige Sicht auf den Islam«, sagt er. Wissen könne man das nicht, denn das Innenleben von GPT-3 ist nicht öffentlich: »Wir bekommen keinen Zugang zu dem Modell, wir können nicht hineinschauen, denn es ist privat.«

Wolf hat sich mit mehr als 500 Forschenden aus 45 Ländern zusammengetan, um das besser zu machen: Die Gruppe, die sich Big Science genannt hat, will das größte und vor allem diverseste Sprachmodell der Welt erstellen. Zunächst müsse man vor allem eine Sache akzeptieren, sagt er: »Wenn Daten von Menschen generiert sind, dann haben sie einen Bias – ganz automatisch, denn wir haben alle einen Bias.« Der muss nicht schlimm sein, das muss nicht gleich Rassismus oder Sexismus sein. Aber Menschen sehen die Welt naturgemäß unterschiedlich.

Das Modell von Big Science wird deshalb mit vielen verschiedenen Texten aus allen erdenklichen Sprachen trainiert. »Allein wenn Sie neben Englisch auch Arabisch drin haben, haben Sie eine viel breitere Perspektive auf Religion«, sagt Wolf, »wenn Sie alle Sprachen in einem Modell nutzen, dann ist es wie ein polyglotter Mensch.« GPT-3 hingegen habe »einen weißen englischen Blick auf die Welt.«

OpenAI ignoriere diesen Fakt bisher, und dadurch bleiben auch die Sprache und Texte, die ein solches Modell produziert, unberechenbar. Wolf hält es für gefährlich, dass Forschende und Unternehmen nicht in der Lage sind, Modelle wie GPT-3 zu überprüfen. Denn so könne man diese nur anhand ihres Outputs bewerten – vielleicht in der Interaktion mit Kunden eines Unternehmens, beispielsweise in Form eines Chatbots. »Wenn der Kunde dann anfängt, über den Islam zu sprechen, wissen Sie nicht, wie das Modell reagiert – Sie können ihm nur blind vertrauen. Und das ist das Gefährlichste, was Sie tun können.« Die andere Lösung wäre, solche Modelle wie GPT-3 öffentlich zu machen – so plant es Big Science mit ihrem Modell. Aber der Trend geht aus Wolfs Beobachtung genau in die andere Richtung. »So kann man diesen Modellen keine Fragen stellen und nicht herausbekommen, wieso sie welche Entscheidung treffen.«

Die Autorin ist Wissenschaftsjournalistin in Stuttgart und schreibt schwerpunktmäßig über Technologiethemen.

Nota. - Der springende Punkt: Man muss etwas erst meinen, ehe man den passenden sprachlichen Ausdruck dafür findet.

Zeitlich: 'erst' und 'dann'? Nein, genetisch: nicht auf-, sondern aus einander: 'um - zu'.

Eine 'von sich aus' sprachlich verfasste Intelligenz wird beides gleichzeitig besorgen - weil sie die Worte meint, weil sie durch Wörter meint. Aber die Maschine meint gar nichts. Um zu meinen, müsste sie sich in eine Stellung gegenüber der Welt setzen, in der sie nolens volens 'existiert'. Die Maschine weiß nicht, wo sie endet und die Welt beginnt - es sei denn, man hätte ihr sowas einprogrammiert, aber ob sie es glauben kann oder nicht, kann sie gar nicht wissen - denn das kann sie nicht unterscheiden. Für sie ist alles Information, woher es auch immer in sie hineingelangt ist - es sei denn (wiederum), irgendwer hätte ihr einen Filter vorgeschraubt, aber sie kann nicht wissen, usw... Ersatzweise zählt sie Häufigkeiten.

Bedenke: Wahrheit ist kein Partikel, das in Raum und Zeit vorkommt, sondern eine Wette, die man wagt; nämlich nichts, was ist, sondern etwas, das man plant, weil man handeln muss.

Merke: Begriffe ohne Anschauung sind leer. Die Maschine hat aber keine Anschauung und macht daher keine Erfahrung. Sie registriert und kombiniert lediglich mehr oder weniger gewohnte Zeichen. Sie weiß gar nichts.

PS. Der Maschine ist nicht nur wurscht, ob das, was sie von sich lässt, wahr ist, sondern auch, ob ihr einer was glaubt.

JE

Wer braucht Chat GPT?

HAL 9000

HAL 9000aus süddeutsche.de, 4. 12. 2022 zu öffentliche Angelegenheiten zu Jochen Ebmeiers Realien

Die gefühlte Revolution findet in einem Dialogformat statt, in dem die menschlichen Nutzer der KI Fragen stellen oder Anweisungen geben und das System dann live die Antwort erstellt. Haben sich bisherige KIs bereits nach wenigen Wörtern oder Sätzen verloren und dabei hanebüchenen Quatsch herbeihalluziniert, kann GPT-3 in seiner aktuellen Form einen "Gedanken" über mehrere Absätze hinweg halten, Folgefragen beantworten, Fehler eingestehen, falsche Voraussetzungen infrage stellen und unangemessene Anfragen zurückweisen.

Geradezu möglichkeitstrunken sind die ersten Benutzer. Sie lassen die KI ganze Theaterszenen schreiben, inklusive der Regieanweisungen oder Songtexte im Stil der Beatles. Sie fragen nach Reparaturanweisungen oder danach, welches Motto ihre nächste Party haben soll. Vor allem Programmierer sind von der Anwendung begeistert. Sie lassen die KI ihren Programmcode auf Syntaxfehler überprüfen oder stellen einfach gleich ein Problem in Schriftsprache, zu dem das System dann den passenden Code liefert. Falls sie das ungute Gefühl beschleicht, mit einer Technologie zu hantieren, die ihre eigene Arbeit bald überflüssig machen könnte, lassen sie sich das nicht anmerken. Chat GPT könnte genauso gut einen Zeitungsartikel über sich selbst schreiben, aber das lassen wir lieber mal, der Autor will seinen Job schließlich noch eine Weile behalten. So was in einer Zeit einzuführen, in der viel zu viele Menschen alles, was sie im Internet finden, für bare Münze nehmen, ist mindestens bedenklich.

Das Versprechen jedenfalls ist offensichtlich: Schon bald ließe sich ein Computer genauso verwenden, wie viele Menschen heutzutage schon Google benutzen. Als Wissensmaschine, die nicht nur mehr oder weniger passende Links ausspuckt, sondern konkrete Fragen beantwortet: Was soll ich tun? Was darf ich hoffen? Was ist der Mensch?

Löst man sich mal kurz von der Bezauberung, fallen einem dann doch ein paar Fragen ein, die man noch gerne stellen würde und auf welche die KI keine Antworten parat hat. Warum, zum Beispiel, tritt Chat GPT in seinen Antworten gleichzeitig so servil und selbstsicher auf?

Es ist geradezu unmöglich, die KI zu einer beleidigenden oder anstößigen Antwort zu bewegen. Offenbar haben die Entwickler ihrem System sehr scharfe Anweisungen dazu gegeben, welche Inhalte angemessen sind und welche nicht. Die Folge? Ein Großteil der Ergebnisse, die Menschen auf den sozialen Medien veröffentlichen, sind Versuche, die künstliche Intelligenz auszutricksen und ihr zu entlocken, wie man einen Molotow-Cocktail oder Crystal Meth herstellt, ein Auto kurzschließt oder eine Leiche versteckt. Manchmal scheint das sogar zu funktionieren. Das Problem sind - wie so oft - die Anwender.

Das zweite Dilemma: Eine solche Technologie einzuführen, in einer Zeit, in der sowieso schon viel zu viele Menschen sämtliche Informationen, die sie im Internet finden, für bare Münze nehmen, und in der kritische Medienrezeption eine lang vergessene Kulturtechnik zu sein scheint, ist mindestens bedenklich. Denn Quellen für die von der Maschine geschriebenen Antworten gibt es nicht.

Das Problem ist eigentlich paradox: Man kann nicht erkennen, ob die KI richtigliegt, wenn man die Antwort auf die gestellte Frage nicht bereits kennt. Dann aber könnte man sich die Zaubertechnologie auch gleich ganz sparen.

Nota. - Das ist das Ergebnis: Wenn KI endlich allgegenwärtig sein wird, ist uns die Welt fraglicher als je zuvor. Kann die KI da nun die Macht übernehmen?

Dass irgendwo in den weltweiten Netzwerken eine Sicherung durchknallt und das ganze System verrückt spielt, ist und bleibt denkbar. Man kann nur hoffen, dass lebendige Intel-ligenz immer wach genug bleibt, um die Fehlerquelle aufzufinden, und den Schaden in Grenzen hält.

Nicht denkbar aber ist, dass die KI wie Kubricks HAL 9000 sich über ihr Schicksal Gedan-ken macht und Algorithmen erfindet, durch die sie es selber in die Hand nimmt. Was kann ich wissen, was muss ich fürchten - was ist der Mensch? Der Mensch ist einer, der seiner selbst bewusst wird, wenn er will. Das ist die KI nicht, auch wenn sie wollte. Ihrer "selbst" bewusst werden kann sie nicht.

Diese Intelligenz hat sich nicht aus dem Eigenwillen eines Lebenden selbstgebildet, sondern wurde nach Plan aus dem Baukasten fix und fertig in die Welt gesetzt. In die Welt, wo sie sich ihre Informationen selber suchen müsste? Eben nicht, sondern ins Labor eines Kyber-neten. Ein Selbst, hinter das sie kommen könnte, hatte sie gar nicht: Sie kann nicht reflek-tieren, nicht hinter sich blicken, denn was hinter ihr stand, war eine andere Intelligenz, die ihr ein Auge dafür nicht eingesetzt hat; und aus der Welt 'zu sich zurück' kommen kann sie nicht, weil sie nie dort war.

Wenn GPT-3 sagt, "ich habe kein Selbstbewusstsein", weiß er nicht, wovon er spricht: Den Satz hat ihm jemand von hinten zugesteckt.

JE

Natürlich kann sie nicht abstrahieren. Abstrahieren ist die Umkehrung von reflektieren. Und natürlich kann sie nicht reflektieren. Denn dazu muss sie wählen können, worauf. Man muss absehen können auf das, was einem wichtig ist, und absehen können von dem, was im Moment nicht zur Sache gehört. Zur Sache: Würde sie der Maschine vorgegeben, bräuchte sie nur zu subsumieren. Doch das ist keine Abstraktion. Man kommt nicht drumrum: Reflektieren und abstrahieren setzen einen freien Willen voraus.

Von im Internet aufgelesenen Vorurteilen abstrahieren könnte sie nur durch freien Willen, den sie nicht hat. Man könnte es ihr auftragen; aber dann unterwirft sie die gesammelten Vorurteile einem neuen - einem äußeren und willkürlichen. Dem kann sie sich unterwerfen.

PS. Was wir landläufig denken nennen, besteht aus reflektieren und abstrahieren.

Kommentar zu Die Maschine kann nicht abstrahieren. 23. 1. 2023

Das Tamtam um die KI spielt nicht mit der Befürchtung, dass sie eines Tages so viel sympathischer als die mehr oder minder intelligenten Lebendigen würde und den Männer die Frauen, den Frauen die Männer und der Queeren die Queeren ausspannen könnte.

Mancher mag meinen, dass die Paarung im Leben das wichtigste und darum unter Menschen das Menschlichste sei. Kaube jedenfalls meint, das Menschlichste am Menschen sei gerade etwas, das er mit anderen Lebenden teilt. Dass sie uns gerade darin überrunden könnte, versetzt aber keinen in Sorge. Sondern uns überrundet in dem, was an den Menschen das spezifisch Menschliche ausmacht - nämlich ihre Vernunft. Dann würde die KI nicht diesen oder jen*innen die Lebensabschnittsgefährt*innen verknappen, sondern wg. größerer Klugheit die Kontrolle über unsere Lebensbedingungen gewinnen und uns beherrschen könnte.

Dabei würden Charme, Leidenschaft und manche liebenswerte Schwäche sie ja nur hindern. Hindern nämlich an ihrer Perfektionierung. Die Vernunft lässt sich aber nicht perfektionieren, weil sie kein Objektivum, kein Absolutum ist, nichts, das an sich und für sich allein bestehen kann. Von künstlicher Vernunft ist bezeichnenderweise ja nicht die Rede, sondern lediglich von Intelligenz, die nie an sich, sondern immer nur im Verhältnis auftritt: die stets nur dient, nämlich einem Zweck. Intelligenz kann unterscheiden und kombinieren, sie ist rein technisch. Zur Vernunft reicht das nicht. Vernunft ist Intelligenz im Dienst der Urteilkraft. Der Kraft, die nicht nur feststellt, was wirklich ist, sondern aufstellt, was sein soll.

Kaube hat nicht Unrecht, wenn er sagt, dass maschinelle Intelligent nicht einmal - und nicht nur einstweilen, sondern definitiv - nicht zu einem Organismus gehört, der selber als deren -Teil in reeller unausgesetzter aktiver Wechselwirkung mit der ganzen Welt steht. Doch selbst wenn sie es täte, fehlte ihr immer noch das Vermögen, zu urteilen. Doch dieses ist der Grund von jenem. Urteilen ist an sich ästhetisch.

Kommentar aus Mehr als bloß ein Turing-Test. 27. 1. 2023

Donnerstag, 14. November 2024

KI ohne Welt.

aus scinexx.de, 13. November 2024 2001, Odyssee im Weltraum. zu Jochen Ebmeiers Realien zu Philosophierungen,

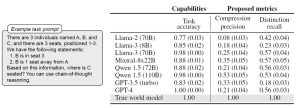

Planlose KI? Auch wenn KI-Modelle uns scheinbar souverän den Weg zeigen können oder Aufgaben lösen – ihnen fehlt ein entscheidendes Element: Die künstlichen Intelligenzen bilden kein korrektes Abbild unserer Welt und ihrer impliziten Regeln, wie nun Tests enthüllen. Die KI-Systeme scheitern dadurch beispielsweise beim Routenplanen an Baustellen oder Umleitungen. Auch in Logiktests oder Strategiespielen zeigen sich diese Schwächen. Das birgt Risi-ken im Einsatz von GPT, Claude, Llama und Co.

Der Fortschritt der künstlichen Intelligenz ist rasant. Inzwischen können die gene-rativen KI-Modelle nahezu perfekte Videos und Bilder erstellen, Forschungsauf-gaben lösen oder wie NotebookLM täuschend echte Podcasts aus beliebigen Doku-menten erzeugen. Sie bestehen den Turing-Test und sind uns in vielen Aufgaben schon überlegen. Wenn es ihren Zielen dient, können die KI-Systeme sogar absicht-lich lügen. Das Verblüffende daran: All diese Fähigkeiten entwickeln GPT, Llama, Claude, Sora und Co durch Auswertung von Wahrscheinlichkeiten in den Trainings-daten.

- Aber was unterscheidet die 'künstliche' von natürlicher Intelligenz?

- Auch historisch entstehen das Ich und die Welt miteinander.

Doch was bedeutet für die „Denkweise“ der KI? Bildet sie durch ihr Training auch eine kohärente Sicht der Welt und ihrer Regeln? „Die Frage, ob Große Sprachmo-delle (LLM) solche Modelle der Welt bilden, ist sehr wichtig, wenn wir diese Techni-ken beispielsweise in der Wissenschaft einsetzen möchten“, erklärt Seniorautor Ashesh Rambachan vom Massachusetts Institute of Technology (MIT). Auch bei KI-Aufgaben, von denen Leben abhängen können, ist es essenziell, dass LLMs im-plizite Regeln und Gesetzmäßigkeiten begreifen – auch ohne, dass man sie ihnen explizit beibringt.

Routen durch New York als Testfall

Ob gängige KI-Systeme eine solche Weltsicht entwickeln, haben nun Rambachan und sein Team getestet. Dafür wählten sie Aufgaben aus der Klasse der sogenann-ten Deterministischen endlichen Automaten (DFA). Dazu gehören beispielsweise die Routenplanung, Spiele wie „Vier Gewinnt“ oder bestimmte Logikrätsel. Typisch dafür ist, dass man eine Reihe von aufeinanderfolgenden Zuständen durchlaufen muss, um die Lösung zu erhalten – beispielsweise das richtige Abbiegen an Kreu-zungen beim Navigieren.

Im ersten Test wurden zwei Version von GPT mit den Routendaten von Taxifahr-ten durch New York trainiert – im Prinzip den Anweisungen, die ein Navi bei sol-chen Fahrten geben würde. Dann sollte die KI selbst als Routenplaner agieren und den Weg zu verschiedenen Zielen in Manhattan angeben. Wie erwartet, schnitt die künstliche Intelligenz sehr gut ab: „Das Transformer-Modell gab in fast 100-Pro-zent der Kreuzungen die richtige Anweisung und schien sogar die aktuelle Position zu kennen“, berichten die Forscher.

Unmögliches Straßennetz

Doch das änderte sich, als das Team Baustellen, Straßenblockaden und andere Veränderungen einbaute. „Ich war überrascht, wie schnell die Leistung in den Keller ging, sobald wir einen Umweg hinzufügten“, berichtet Erstautor Keyon Vafa von der Harvard University. „Wenn wir nur ein Prozent der Straßen blockierten, sank die Quote der korrekten Zielführungen von fast 100 auf nur noch 67 Pro-zent.“ Die künstliche Intelligenz „verirrte“ sich in den Straßen von New York.

Der Grund dafür zeigte sich, als die Forscher sich die von der KI im Verlauf des Trainings und der Aufgaben angelegten „mental Maps“ anschauten: „Die resultie-renden Karten zeigen wenig Ähnlichkeit mit den echten Straßen von Manhattan. Sie enthalten Straßen mit unmöglicher Orientierung und nicht existente Verbindun-gen in ‚Luftlinie'“, berichtet das Team. „Das enthüllt, dass die zugrundeliegenden Weltmodelle dieser künstlichen Intelligenz nicht kohärent sind.“

Scheitern an impliziten Gesetzmäßigkeiten

Diese fehlende oder falsche Weltsicht der KI ist jedoch nicht nur für die Navigation problematisch: Auch bei Tests mit Strategiespielen wie Reversi und Vier Gewinnt sowie Logikrätseln zeigt sich fehlende Einsicht in die dahinterstehenden Prinzipien. So konnten die anhand realer Spielzüge trainierte KI-Modelle GPT-4 und Llama zwar die Spiele gewinnen. Sie erkannten aber beispielsweise nicht, ob sie in zwei Durchgängen identische Spielzustände erhielten oder dass verschiedene Eröffnun-gen letztlich zum gleichen Ergebnis führen können.

Ähnlich lief es beim Logiktest, in dem anhand einer Sprachaufgabe die Sitzreihen-folge von drei Leuten auf einer Bank ermittelt werden sollte. Wurde die Aufgabe leicht anders formuliert, erkannte die künstliche Intelligenz nicht mehr, dass es im Prinzip die gleiche Aufgabe war. „Kein KI-Modell erreicht dabei mehr als 40 Pro-zent“, berichten Vafa und seine Kollegen. Auch hier fehlte den KI-Systemen ein übergeordnetes Verständnis, eine kohärente Weltsicht.

Schwachstelle der KI-Modelle – noch

Nach Ansicht der Forscher bestätigt dies eine wichtige Schwachstelle der künstli-chen Intelligenzen: Selbst wenn sie verblüffende Leistungen erbringen und komple-xe Aufgaben souverän meistern: Noch reichen ihre Fähigkeiten nicht aus, um sich aus ihren Trainingsdaten und Erfahrungen immer ein korrektes Abbild der Welt und ihrer Gesetzmäßigkeiten zu machen. Wird ihnen dies nicht explizit beigebracht, können sie dadurch an unerwarteter Stelle scheitern.

„Wir sehen, wie diese KI-Modelle beeindruckende Dinge tun, und denken daher, sie müssen das Prinzip dahinter verstanden haben“, sagt Rambachan. Aber bisher sei dies nicht immer der Fall. Das könnte dann gefährlich werden, wenn eine für essenzielle Aufgaben eingesetzte künstliche Intelligenz in einem Kontext bestens funktioniert, dann aber unerwartet scheitert. „Es wäre daher immens wertvoll, wenn wir generative KI-Modelle entwickeln, die auch die zugrundeliegende Logik selbstständig erfassen können“, so der Forscher. (Preprint arXiv, 2024; doi: 10.48550/arXiv.2406.03689)

Quelle: Massachusetts Institute of Technology (MIT) - 13. November 2024 - von Nadja Podbregar

Nota. - Noch? Das dürfte so bleiben - dass der künstlichen Intelligenz ein Bild der Welt vorgesetzt werden muss, damit sie eine erkennt; weil sie nämlich selber schlech-terdings nicht in der Welt ist - sondern in einem Laboratorium, in dem ihr alle Da-ten, die sie kennen soll, von außen zugeführt werden müssen,

Natürliche Intelligenz existiert in einem lebenden Organismus, wo er alles, was er weiß, in der Welt erfahren muss, in der er - und sei es durch lesen - tätig ist: Er kann es selber herausfinden. Das kann eine Mascine nicht. Sie kann sich von der Welt kein Bild machen, weil sie es gar nicht braucht.

Wirkliches Wissen stammt aus Erfahrung, und die entsteht durch die Verbindung von Begriffen und Anschauungen. Eigne Anschauungen hat eine künstliche Intel-ligenz nicht.

14. 11. 2024

Keine Kommentare:

Kommentar veröffentlichen